主题

从原始数据到高质量标注:标注系统背后的流水线是如何运作的?

在人工智能时代,无论是大规模模型训练,还是智能 Agent 的行为调优,都越来越依赖于海量且高质量的数据作为基础。然而,原始数据就像天上的雨水——资源丰富,却未经处理,难以直接使用。为了真正"灌溉"大模型成长,这些数据必须通过专业的数据标注系统,转化为可供训练的结构化标签。然而,随着数据规模与标注任务复杂度不断提升,传统的"线性+人工驱动"流程暴露出多重痛点:

- 流程状态多、节点复杂,人工协调成本高;

- 大批量任务同步处理困难,常出现瓶颈;

- 多团队协作场景下,权限控制和任务路由不灵活;

- 模型辅助标注、主动学习仍难有效落地;

- 标注成本持续高企,质量与速度难以兼顾。

那么,如何构建一个既高效又可扩展、能够支持人机协作和质量追踪的标注系统数据流水线,以应对海量数据和复杂流程的挑战?在本文中,我们将重点讲述工作流设计,深入拆解一个现代标注系统流水线。

从作坊式协作到工业化流水线

在大模型的训练链条中,数据标注是最基础也是最关键的一环。许多组织意识到标注工作的重要性后,开始大规模组建标注团队,数百甚至上万人共同作业,试图以"人海战术"完成任务。但现实很快给出了答案:

人多 ≠ 高效,堆人 ≠ 提质。

不是把 1 万个专家拉进一个群,就能自动产出优质数据。就像早期的乡镇企业,哪怕有成千上万的工人,如果缺乏标准化流程、组织结构与质量控制,生产出来的只能是低端粗糙的产品。只有像现代自动化工厂那样高度组织化、精密协作的体系,才能让上万人协同制造出 iPhone、MacBook 这样的世界级产品。

数据标注也是如此。要产出高质量、结构化、可复用的数据,靠的不是人头数,而是一套高效的组织机制与可控的任务流程。尤其在如今多角色、多阶段、多轮校审的标注场景中,协作的复杂度远远超出传统项目。缺乏体系化机制,最终只会带来这些问题:

- "人浮于事":任务分配混乱、效率低下;

- "质量不稳":审核缺位,质检缺失;

- "交付延期":流程中断,信息滞后;

- "智能失灵":缺乏有效的模型辅助与主动学习等机制,效率难以提升。

传统工作流能解决这些问题吗?

面对混乱的标注协作,很多组织尝试引入企业级工作流系统,希望用通用流程框架来统一管理标注任务。然而实际落地中发现——好工具,不一定适合这个场景。

| 问题类型 | 表现 |

|---|---|

| 流程刚性强 | 标注任务变化频繁,传统流程难以灵活应对 |

| 协同反馈弱 | 无法实时掌握任务状态、质量得分、审核意见 |

| 数据闭环缺失 | 模型辅助标注无法流入二次训练环节,浪费数据 |

| 控制逻辑不足 | 不支持打回重做、仲裁判断、抽检质控等操作 |

| 接入成本高 | 多数开源工作流工具门槛高、定制复杂,维护困难 |

传统工作流强调"流程流转",而标注系统更强调"协作效率 + 数据质量 + 闭环反馈"。两者虽有交集,但并不完全适配。

为标注构建真正的"精密流水线"

我们认为,更可行的路径是:

借鉴传统工作流思想,结合标注业务实际,打造专属的数据生产协作系统。

这类系统需要满足以下关键特性:

- 批次驱动:任务以批为单位流转,便于进度监控与质量分析;

- 角色协作机制:支持标注、复审、质检等角色并行作业、流程打通;

- 数据闭环支持:模型预标注、人工审核、质量回流、主动学习形成反馈链条;

- 状态全可视:每一节点、每一批次、每一条数据的状态都可追踪;

- 流程灵活演化:支持任务打回、抽检、再分发等动态流程配置。

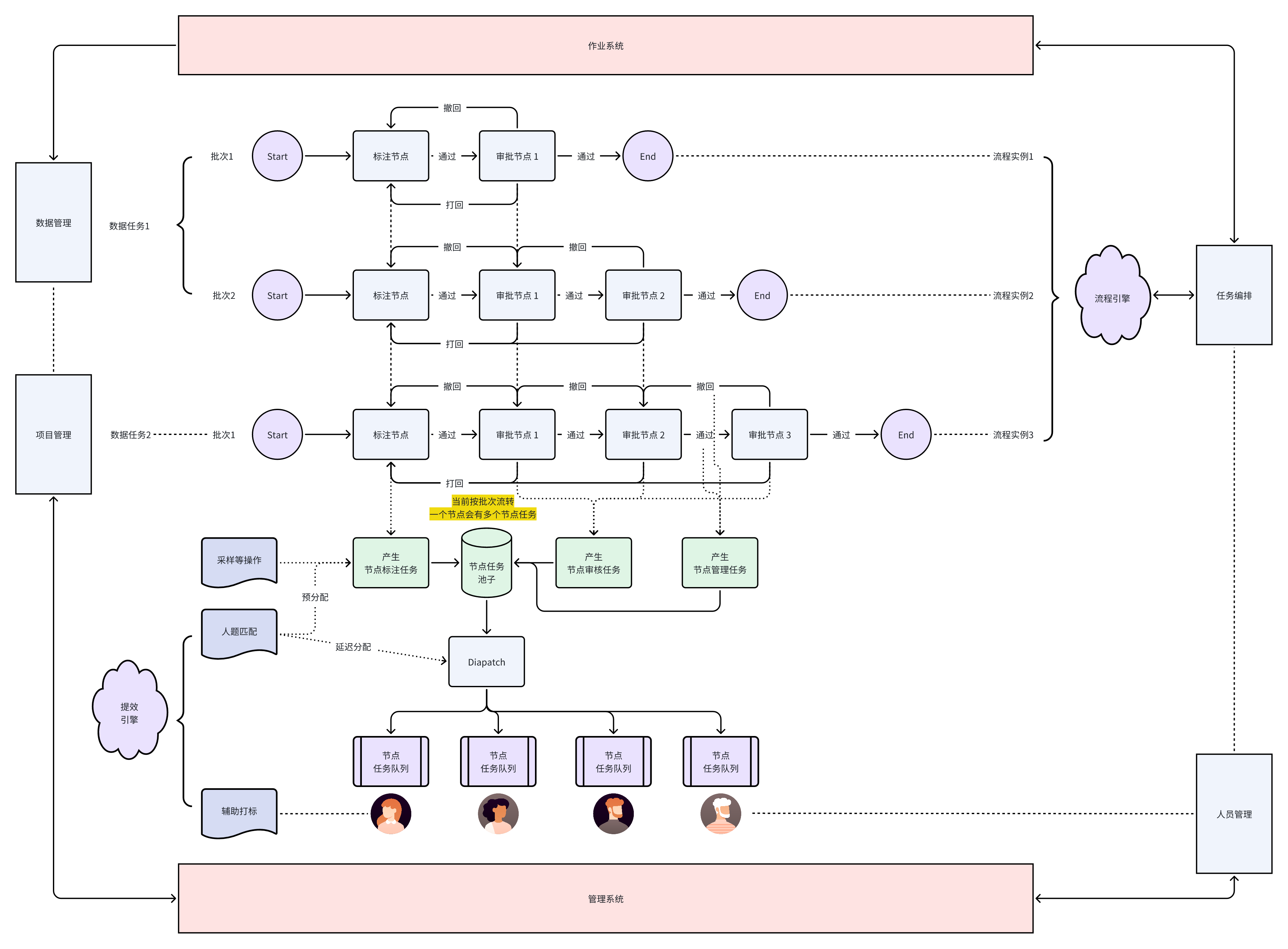

智识工作流整体示意图

下图为智识工作流整体示意图,可以看到工作流、各类系统的紧密而又条理地配合,接下来将详细介绍图中核心设计模块。

工作流设计

批次驱动 vs 单条任务驱动

在标注系统中,工作流的最小执行单元通常有两种设计:

🔹 Batch-first(常见设计)

以批次为单位:如将 100 条样本打包成一个批次,一次性流转到下一个节点进行处理。

优点:

- 效率高:批量并行处理大幅提升吞吐量;

- 监控方便:可按批次统计进度、错误率等指标;

- 失败隔离容易:批次出问题可单独重跑或回滚。

实践平台:

Scale AI、Labelbox等均以 Batch 为核心管理粒度,任务分发与审核均围绕批次展开。

⚠️ Task-first(细粒度策略)

以单条数据为单位:每条样本单独流转与处理。

优点:

- 调度灵活:支持单条高优先级或复杂样本插队;

- 状态精细:可实时查看每条数据的处理状态。

缺点:

- 系统复杂度高:调度性能压力增大;

- 管理难度大:批量监控、统计和优化变得复杂。

主流平台倾向于"Batch-first + Task-level执行":批次控制流转节奏,批内以任务为颗粒处理,实现效率与灵活性的平衡,本文主要介绍基于批次的流转,后续文章中也会介绍workflow pipeline的实现。

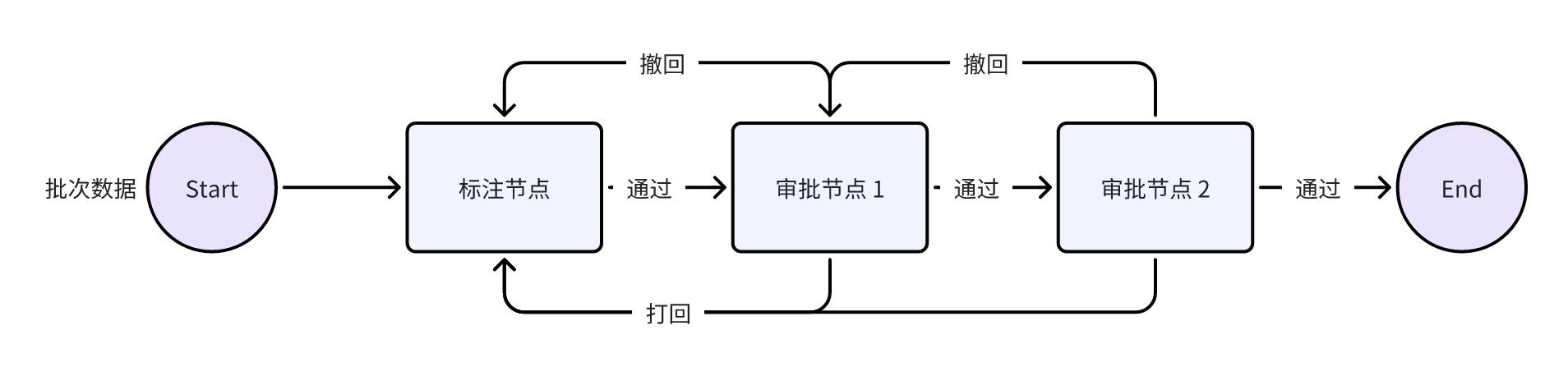

为什么重新定义"节点(Node)"?

为了支持每个阶段灵活调度、审核以及动态控制,标注系统将流程抽象为若干节点单元(Node),每个节点具备明确的职责。

责任分明:每个节点只做一类事情

- 【标注节点】负责生成标注任务;

- 【审核节点】负责生成审核任务;

节点内还会对应"是否通过"的决策逻辑,触发下一节点或重做流程。

这种结构清晰、职责分离,有助于流程维护与扩展。智识工作流可以更简单抽象为图示:

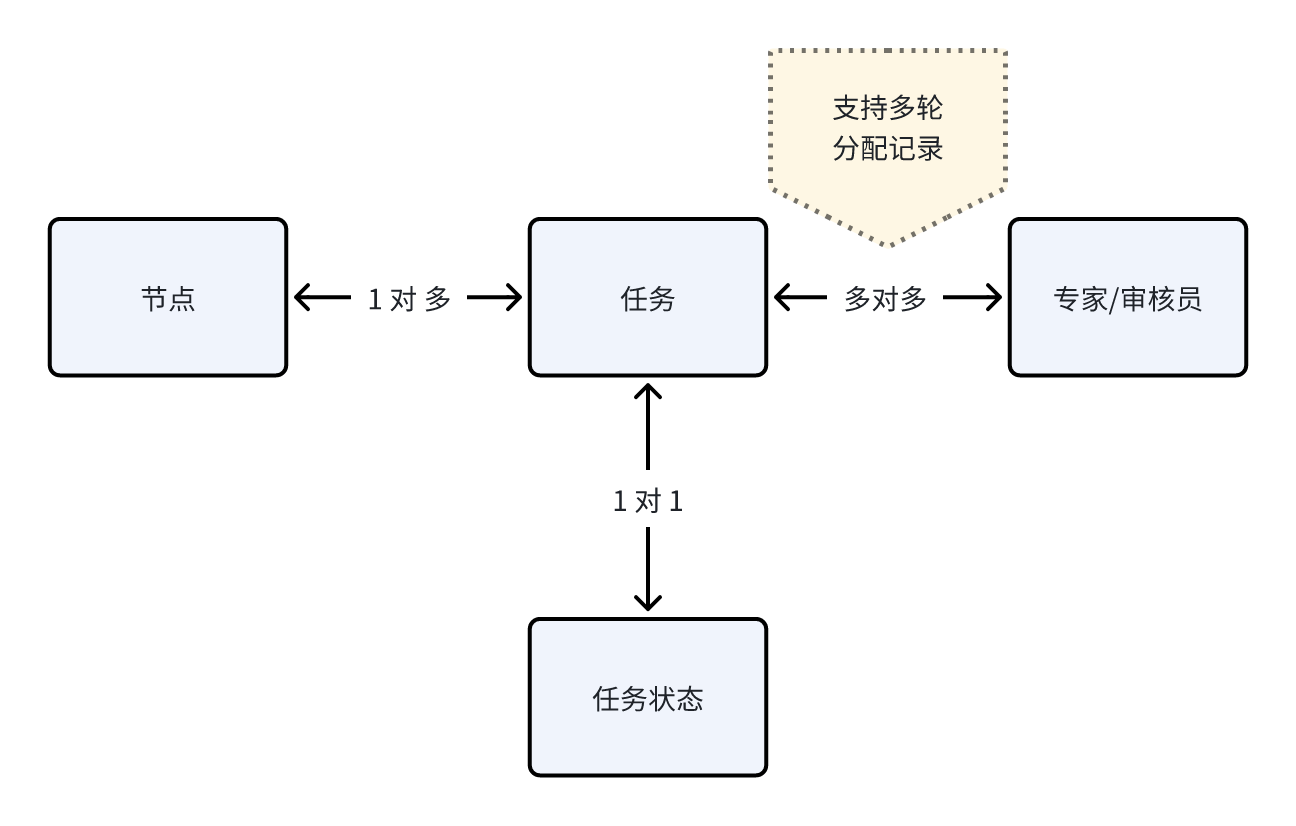

整体逻辑上更清晰,进一步隐藏和收敛了任务分配、审核这些复杂逻辑。每个节点上可以产生海量的任务,节点与参与人员可以灵活绑定,在节点内部设计了一套灵活的匹配以及状态映射关系。节点中实体的对应关系:

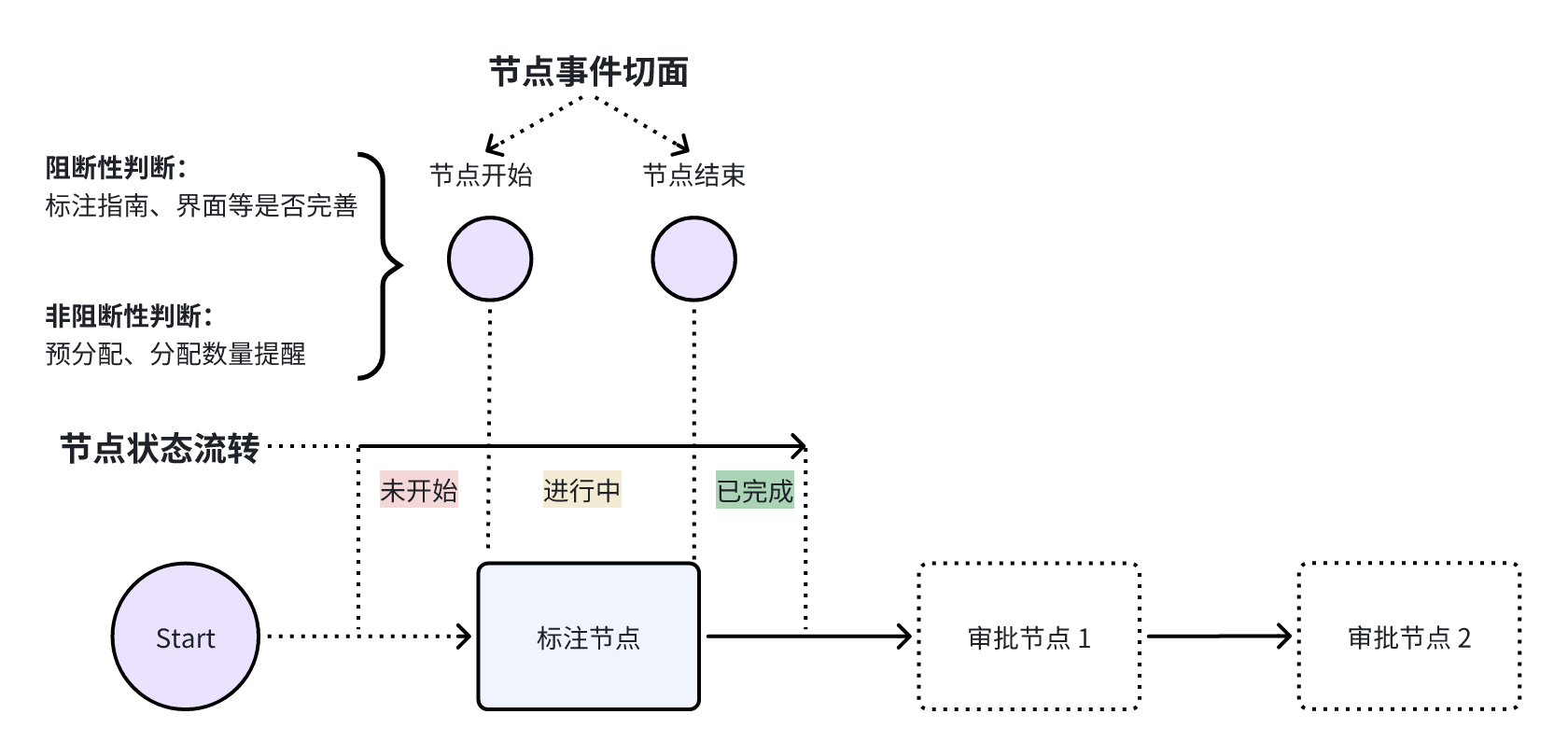

我们采用批次作为基本单位在工作流中流转,每个批次由多个数据条目构成,为了进一步抽象系统设计,采用两级状态构成以及事件处理切面。

节点状态以及处理切面

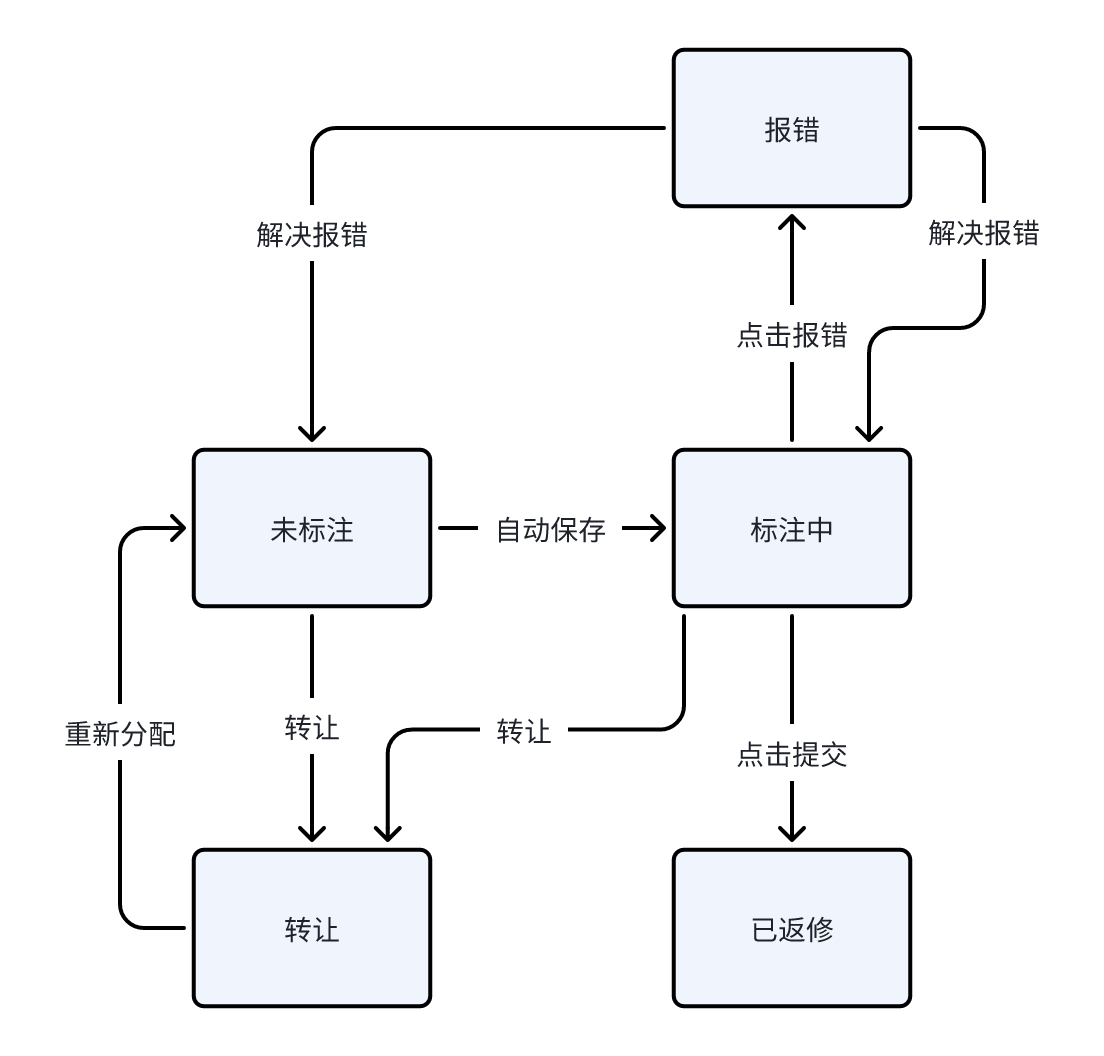

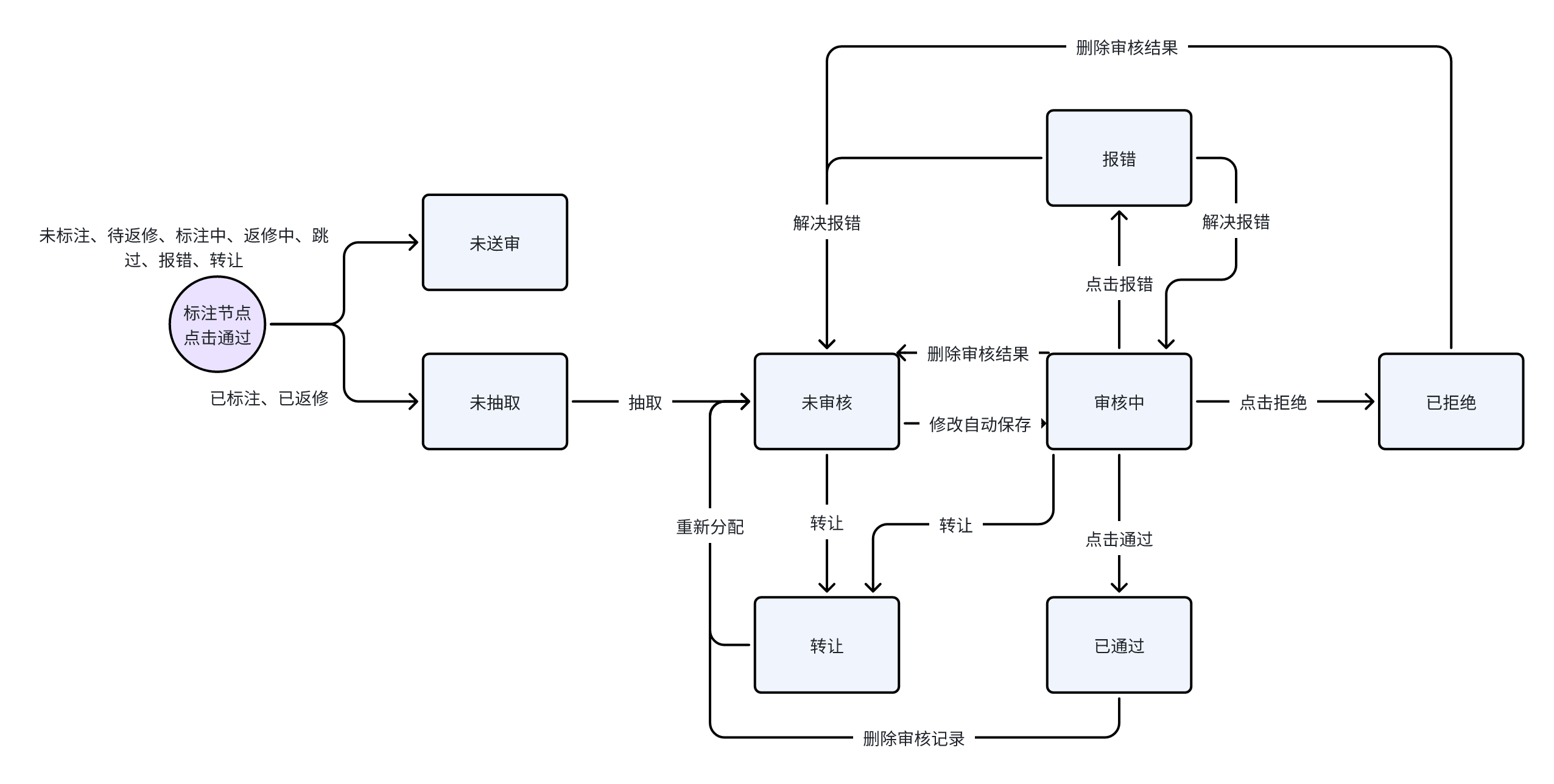

为了避免过于复杂的节点状态设计,我们将节点的状态简化为三种最基本的形态:未开始、进行中 和 已完成。这种简化有助于提升系统的可理解性和可维护性。同时,需要特别说明的是:任务状态与节点状态是彼此独立的。任务状态如图所示:

| 标注任务状态流转: | 审核任务状态流转: |

|---|---|

|  |

每个节点下可以包含多个具体任务(如标注任务、审核任务等),这些任务各自拥有独立的生命周期(如"未标注"、"标注中"、"已标注"、"审核中"等)。节点状态通常反映的是整体流程的阶段性进度,而任务状态则体现单条数据在微观操作层面的处理状态。这种解耦设计有助于系统更灵活地处理并发、多角色协作及状态回滚等复杂场景。

在状态转换的过程中,我们也预留了必要的"切面动作"(Hook Actions),以保障专家或审核人员在执行任务时能够及时发现并避免潜在错误。这些动作主要分为两类:

- 阻断性判断:用于执行关键逻辑校验,例如界面配置是否完整、节点成员是否配置合理等,若校验失败将直接阻止状态流转;

- 非阻断性判断:用于提供用户提示或预警信息,不影响状态流转,但提醒用户注意可能的问题。

这种机制在保障流程稳定运行的同时,也增强了系统的容错能力与用户体验。

人题分配

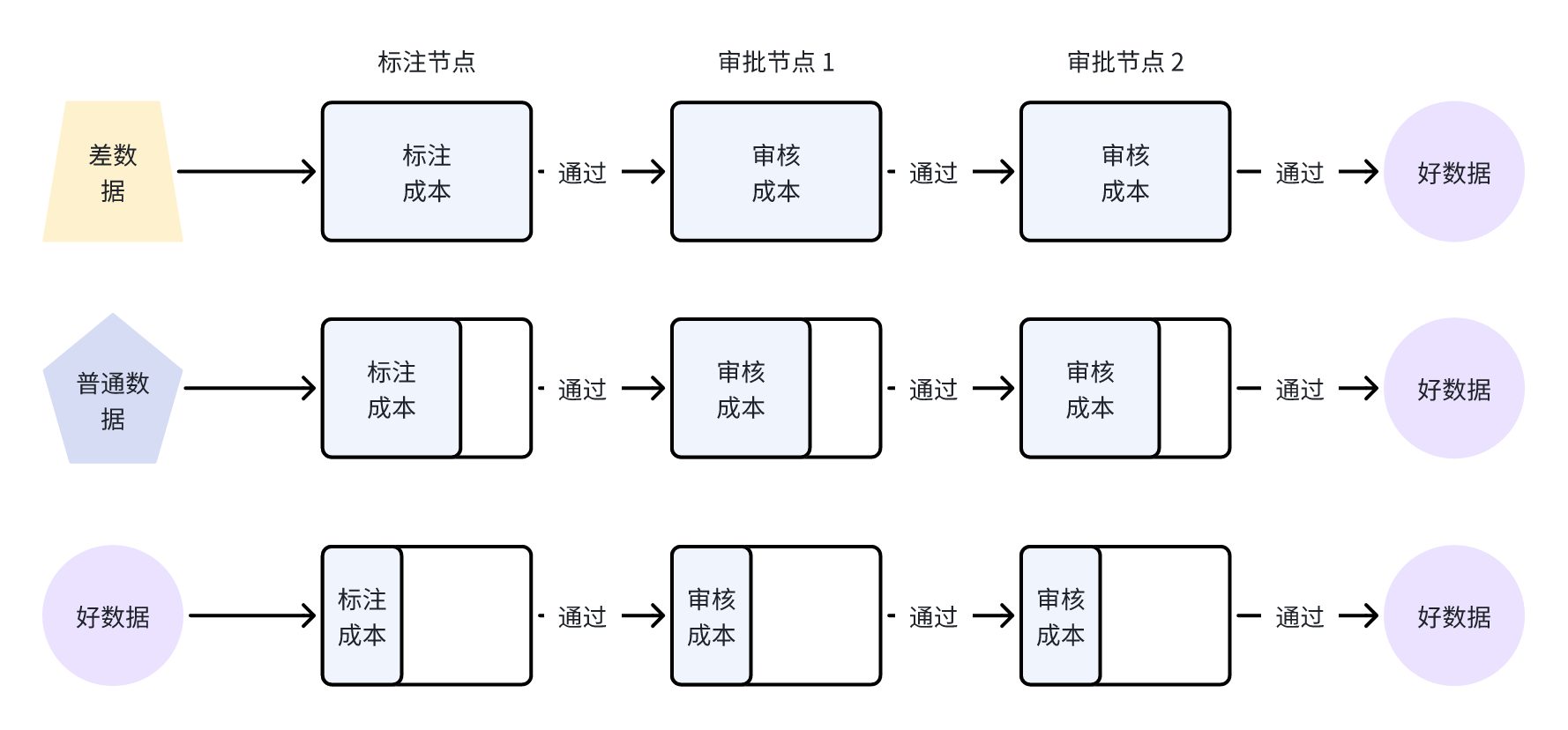

核心理念:缺什么补什么,优则不过审

我们在流程设计中坚持一个核心理念:"缺什么,补什么;好数据,无需反复审"。这不仅避免了资源浪费,也让数据质量提升更具针对性和效率。为实现这一理念,系统引入了多种智能化任务分配机制,用于根据任务特性与数据表现,动态匹配最合适的处理方式:

自动分配(预分配机制)

在节点启动前,系统可基于预设规则进行自动分配,如:

- 每人任务上限;

- 数据类型或标签类别筛选;

- 采样比例控制(如部分数据进入审核);

- 团队或角色权限控制等。

这种方式适合结构清晰、数据量大、流程稳定的节点场景,确保任务启动即分发,提升流转效率。

手动批量分配(即时指派)

管理员可根据任务到达时间、标注压力、个人空闲情况,实时进行任务分发,也支持结合AI推荐结果快速一键指派。这种方式适用于:

- 急需分配的小批量任务;

- 任务流量波动较大的场景;

- 需要人工把控责任归属的节点。

AI 智能分配(精准调度)

系统支持基于以下要素进行AI驱动的任务调度:

- 成员历史表现(准确率、处理效率等);

- 数据任务优先级(如紧急修复、核心训练数据);

- 知识领域匹配度(专家擅长领域与任务内容对齐);

- 过往错误类型与当前任务的相似性等。

该机制有助于将关键任务交由最合适的人处理,提升整体产出质量,降低返工率。

在我们的系统中,每一个数据条目都有它"生命周期"中的流转轨迹。借助智能化的匹配引擎,它们被动态地分配给最合适的人,以最合适的方式处理。这不仅提升了数据的处理效率,也让每一条数据都"物尽其用,流转有序"。

通过以上分配策略的组合应用,系统能够动态平衡任务难度与人力资源,实现"好数据快速通过、疑难数据重点关注"的高效协作闭环,最终实现标注资源的最优利用与数据质量的精准提升。

精细化任务视角与沉浸式执行体验

为了更好地服务不同角色在数据任务中的职责与使用习惯,我们在系统中设计了分角色视角与沉浸式作业机制,实现了从管理到执行的全流程高效协作。

管理员 vs. 成员:角色视角分离

系统为不同角色提供了差异化的使用体验:

- 管理员视角:专注于全局任务管理与质量控制。可查看任务分布、进度统计、质量趋势、异常数据等核心指标,具备任务分配、打回控制、流程调整等高级操作权限,确保整个数据流程稳定可控。

- 成员视角:强调"所见即所得"的专注体验。成员无需关心全局配置,只需聚焦当前处理任务,界面清晰简洁,屏蔽无关干扰,使其更专注于每一条标注或审核操作,提升效率与准确率。

这种视角分离机制有效划清了角色边界,强化了管理层与执行层的协作分工,为项目稳定推进提供了良好的基础。

沉浸式作业队列:像刷短视频一样干活

为进一步提升成员的执行效率,我们为其设计了任务队列机制。系统会根据优先级、分配策略或AI推荐结果,将任务排成待处理序列,成员只需点击开始,即可进入"连刷模式":

- 像刷短视频一样,一条接一条处理任务,不中断、不跳出;

- 每次专注当前任务,避免多任务干扰,提升准确率;

- 可配置是否允许跳过、暂停,支持个性化流转逻辑;

- 完成后即时进入下一个任务,配合进度提示或激励机制,提升用户粘性。

这一机制尤其适用于需要大量处理的标注或审核节点,让任务执行更流畅、体验更轻松、效率更高。通过角色视角的精细划分与沉浸式任务体验的结合,我们构建了一个既能统筹全局、又能深入执行的高效数据处理系统,实现了人力协同效率与数据质量的双重提升。

封装共识机制:Vote

借助基于"人题分配"机制的灵活性,系统支持将同一条数据任务分配给多位专家,从而在平台上实现类似投票的机制。通过多位专家的独立标注结果,系统可自动执行多数投票(Majority Vote)逻辑,确定最终标注结论。在每个节点内,支持以下能力:

- 并行生成多个标注任务,分发给不同专家;

- 自动聚合结果并执行 Majority Vote 机制;

- 判断是否满足质量门槛,必要时流转至下一轮复核。

该机制在确保标注质量的同时,避免了流程图中出现冗余复杂判断结构,使流程更清晰、可维护。

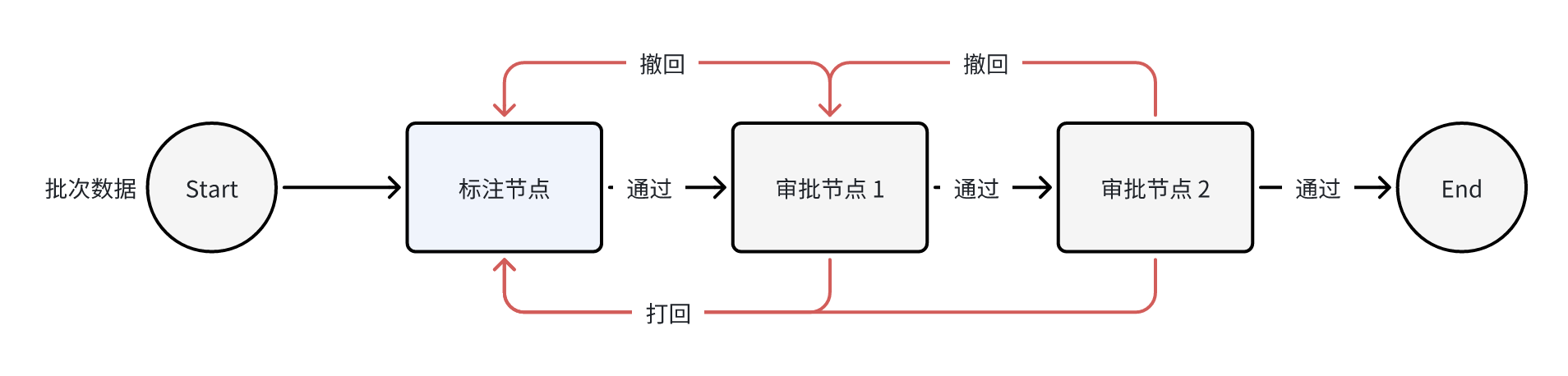

撤回与打回机制:保障数据质量与流程灵活性

- 撤回:在前一节点操作完成并通过后、即将进入下一节点审核前,我们为用户提供了一次"反悔"的机会。如果在此时发现上一节点的标注质量存在问题,管理员或节点负责人可以主动将流程撤回到上一节点,避免低质量数据进入审核流程,提升整体效率。

- 打回:当审核节点发现当前批次整体标注质量不达标时,可触发打回操作,将整个批次退回至原节点,要求任务执行人重新修正存在问题的数据项。

值得强调的是,打回并非重复劳动,而是一次有针对性的数据迭代过程。系统支持多轮打回,且每一轮都聚焦于未修正或新增发现的问题,帮助用户逐步收敛至高质量数据。这一机制也体现了我们设计中的"优化迭代"理念:随着流程推进,数据质量在迭代中持续提升,工作量则逐步收敛,避免重复无效劳动。

为确保"打回"操作不仅仅停留在流程退回,还能有效促进任务质量的提升,我们在系统中引入了一系列配套能力,形成完整的闭环反馈体系:

打回记录追踪

每一次打回操作,系统都会记录操作人、时间、原因、打回范围(批次/数据项)等关键信息,形成可追溯的历史日志。这些记录可供:

- 项目管理者复盘决策过程;

- 标注人员理解修改要求;

- 多轮打回时作为版本变更参考。

同时,系统还支持对打回记录进行标签化分类,如"标注缺失"、"类型错误"、"模糊定义"等,便于统计分析和质量评估。

评论协同机制

每个任务或批次节点下均支持评论区或问题讨论区,审核人员可以就具体问题发起评论,@相关成员、引用任务项,甚至附带截图、示意或标注说明。标注人员则可在评论中回复澄清,形成闭环沟通。这种机制显著提升了协同效率,尤其在远程、多团队协作的项目中,可替代大量线下口头沟通。

差分视图

为支持多轮打回下的数据修订可视化,系统引入了"差分视图"功能。每次打回后系统会自动将不通过的条目分配对应返修人员,并以可视化方式呈现返修哪些标注任务,新增了哪些评论等。这种展现视图不仅帮助审核人员聚焦本轮修改点,也使整个迭代过程更清晰透明,避免反复检查未修改部分。

打回后的人员分配策略

在批次被打回后,系统提供灵活的人员处理策略配置:

- 保留原处理人员:用于确保原始责任人对任务进行复修,便于责任闭环和针对性改进;

- 重新分配人员:用于在资源变更或原人员不适合继续参与时,将任务交由其他团队或成员重新处理。

管理员可根据任务类型、错误性质、资源安排等因素,灵活选择处理策略,进一步提升协同效率与质量控制能力。

在智能时代,数据标注早已不再是单点作业的"体力活",而是贯穿数据生命周期、承接模型质量、驱动闭环优化的核心环节。我们尝试通过引入流程抽象、角色分离、人机协作与智能调度等理念,重构标注系统的底层逻辑,让任务分发更精准、协作更高效、质量更可控。

这不仅是对传统工作流的继承与升级,更是对 AI 时代数据基础设施的一次重塑。未来,随着模型能力持续增强、数据需求持续增长,一个灵活、高可扩展、面向质量的标注流程系统,将成为每一个智能体背后的"数据发动机"。

让标注不再是负担,而是智能跃迁的起点。